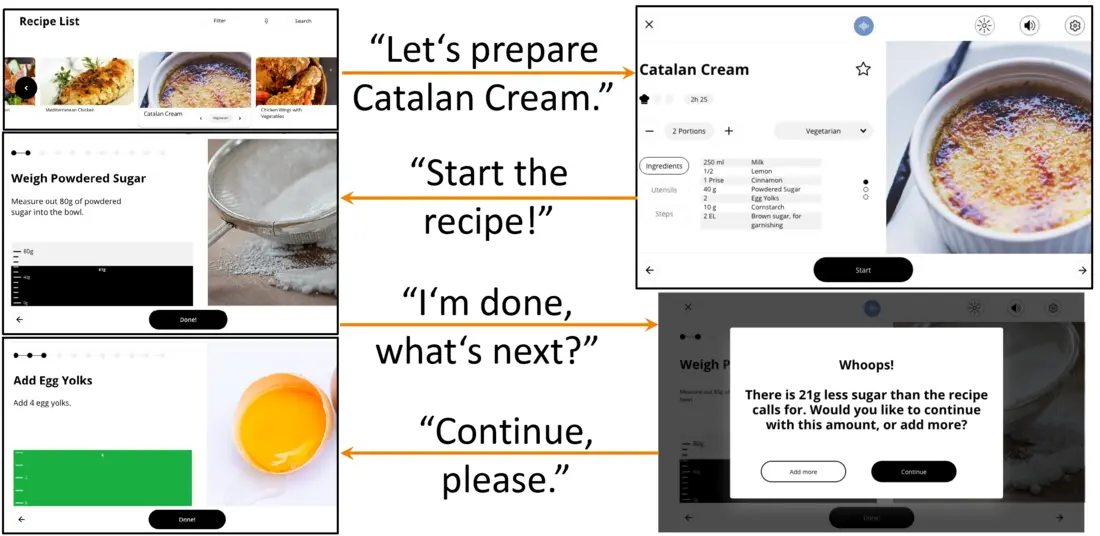

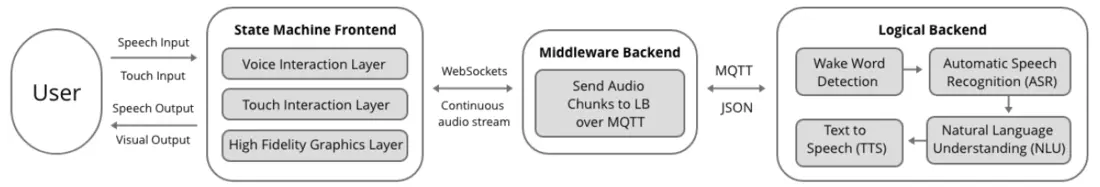

Multi-modale Interaktionsmöglichkeiten bieten ein hohes Maß an Zugänglichkeit, Neuartigkeit und Nutzerfreundlichkeit bei intelligenten Küchengeräten.

Im Rahmen des UX-Design Masterprojekts Natural User Interfaces im Sommer 2021 präsentieren wir das Design und die prototypische Implementierung einer solchen multi-modalen Interaktion:

Geleitetes Kochen mit einer intelligenten Küchenmaschine, die neben Touch-Gesten auch Nutzereingaben in Form von Sprache akzeptiert und über eine Sprachausgabe verfügt. So steht der Bedienung einer smarten Küchenmaschine nichts mehr im Weg, selbst wenn die Hände verschmutzt oder gerade nicht frei sind.

Im Rahmen des Projekts ist ein Paper entstanden, das auf der ICNLSP 2021 akzeptiert wurde: https://aclanthology.org/2021.icnlsp-1.30

Der Code zum Prototyp ist auf GitHub unter folgendem Link verfügbar: https://github.com/VoiceCookingAssistant/Audio-Visual-Cooking-Assistant